활성화 함수(Activation Function)- ReLU

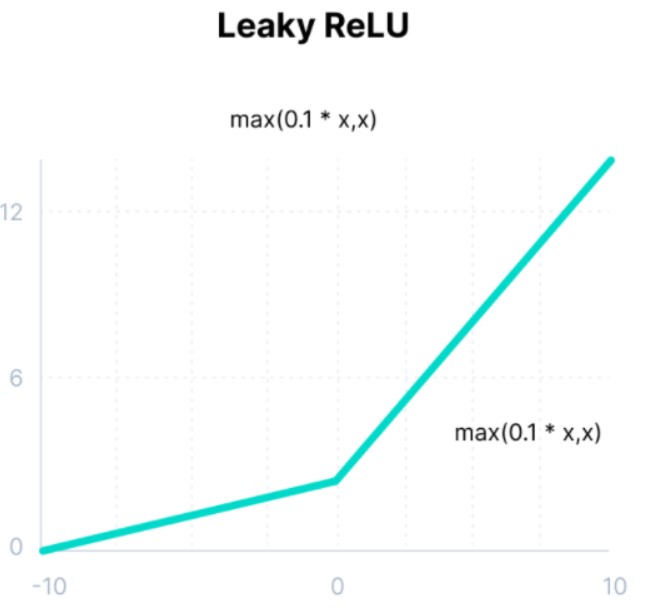

1. Leaky ReLU 함수

Leaky는 ‘새는, 구멍이 난’이라는 뜻으로 ReLU에서 발생하는 Dying ReLU 문제를 해결하기 위해 만든 함수입니다. 기존 ReLU함수는 음수를 모두 0으로 해준 반면 Leaky ReLU 함수는 음수를 0.01배를 해준다는 차이가 있습니다.

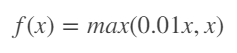

수식은 다음과 같이 나타낼 수 있습니다.

Leaky ReLU 함수는 음수에 아주 작은 값을 곱해 Dying ReLU 문제를 해결하고자 ReLU보다 균형적인 값을 반환해줍니다. 이로 인해 학습이 더 빨라지는 장점을 가지고 있습니다. 하지만 Leaky ReLU 함수도 음수에서 선형성이 생기고 그로 인해 복잡한 분류문제에서는 풀 수 없다는 문제가 발생합니다. 음수가 중요하지 않은 문제에서는 사용하는 것을 추천드립니다.

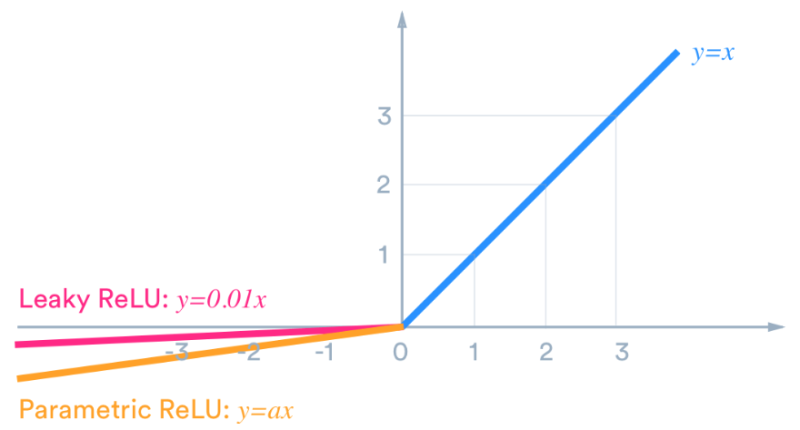

2. Parametric ReLU(PReLU) 함수

Leaky ReLU와 거의 유사하지만 새로운 파라미터(상수를 원하는 값으로 설정) α 를 추가해 x가 음수인 영역에서도 기울기를 학습해줍니다.

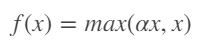

수식은 다음과 같이 보입니다.

PReLU 함수는 문제에 따라 상수를 원하는 값으로 설정해줄 수 있다는 장점이 있습니다. 다른 장점은 Leaky ReLU 함수와 유사합니다. 하지만 PReLU 함수는 기존 함수들과 달리 상수를 원하는 값으로 설정해줘야 하기 때문에 문제에 따라 상수값을 계속 설정해줘야 됩니다.

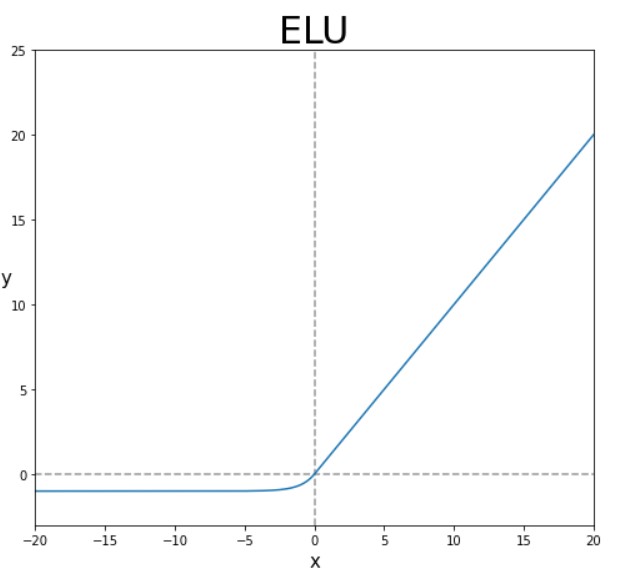

3. Exponential Linear Unit(ELU)

Exponential Linear Unit은 2015년에 나온 최근 방법으로 ReLU의 모든 장점을 포함하며 Dying ReLU 문제를 해결해줍니다. 일반적인 ReLU와 다르게 exp 함수를 계산하는 비용이 발생한다

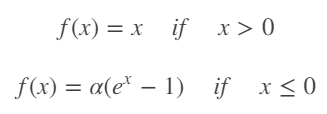

수식은 다음과 같이 보입니다.

ELU는 ReLU와 유사하지만 exp를 사용해 그래프를 부드럽게 만들어주며 미분 시, 0에서 끊어지는 ReLU의 문제를 보완해줍니다. ELU는 Leaky ReLU나 PReLU와 달리 음에서도 비선형적이기 때문에 복잡한 분류에서도 사용할 수 있습니다.

ReLU와 유사한 함수들을 봤습니다. 각각의 장단점이 있어 문제에 접근할때 각각의 성능을 비교하며 ReLU함수를 사용하면 됩니다.

댓글남기기